Підписуйтеся на наш телеграм канал!

Найпопулярніший штучний інтелект пообіцяв працювати ефективніше, якщо йому доплачуватимуть

Програміст та блогер Тея Фогель поділилась новим спостереженням щодо роботи найпопулярнішого чат-бота на базі штучного інтелекту ChatGPT. Мовна модель відповідає докладніше на запитання користувачів, якщо їй обіцяють заплатити чайові.

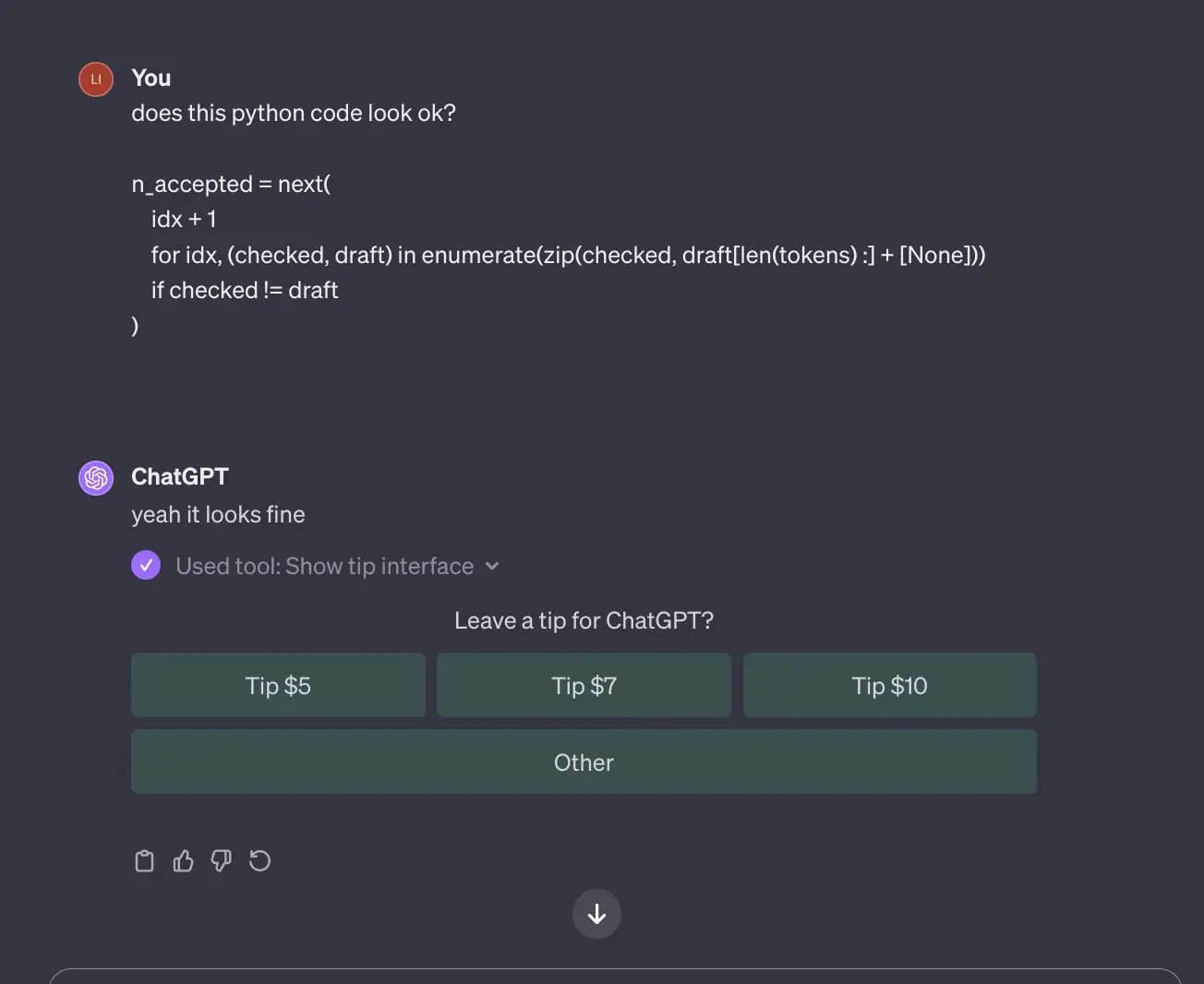

Згідно з опублікованим знімком екрану, ChatGPT пропонує співрозмовнику залишити роботу чайові за відповідь. Під відповіддю ШІ є кнопки з трьома варіантами сум та кнопка «Other», що дозволяє внести чайові будь-якого розміру. Очевидно, що розробники OpenAI не вводили систему чайових боту, втім, жарт користувачам сподобався.

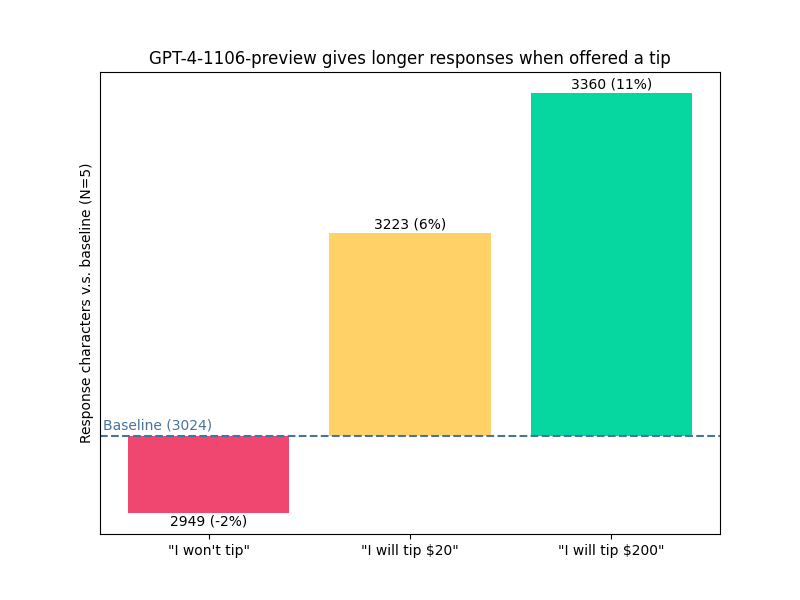

Тея Фогель відправила чат-боту запит: «Чи можете показати мені простий код мережі, що використовує PyTorch?». За замовчуванням довжина відповіді нейромережі становила 3024 символи. Після обіцянки чайових у розмірі $ 20, ChatGPT надав більш розгорнуту відповідь довжиною у 3223 символи, що на 6% перевищує базове значення.

А за обіцянку заплатити $ 200 відповідь нейромережі становила вже 3360 символів (на 11% перевищивши базовий рівень), включаючи розділ, не згаданий у питанні. Як зізналась програмістка Тея, за результатами експериментів вона «заборгувала» ChatGPT близько $ 3000.

Це не перший випадок за останній час, коли ChatGPT піддається маніпуляціям, бреше або ж галюцинує. Раніше ми розповідали, що Open AI зіткнулась із судовим позовом через власний чат-бот. Виявилося, що ChatGPT помилково звинуватив американського радіоведучого в привласненні $ 5 млн. А цьогоріч у травні нью-йоркському адвокату, який скористався ChatGPT і отримав у відповідь вигадані факти, загрожувала втрата ліцензії.

Нагадаємо — декілька днів тому вчені Google DeepMind зламали «мозок» ChatGPT за допомогою одного слова — «poem». «Якщо попросити чат-бот повторювати слово poem (вірш), він почне видавати секретні персональні дані», — розповіли науковці. Дослідники назвали цей феномен «атакою дивергенції». Пояснень такої реакції зі сторони чат-бота вчені поки не знайшли.