Підписуйтеся на наш телеграм канал!

Штучний інтелект вперше в історії розробив ефективний алгоритм для боротьби з раком

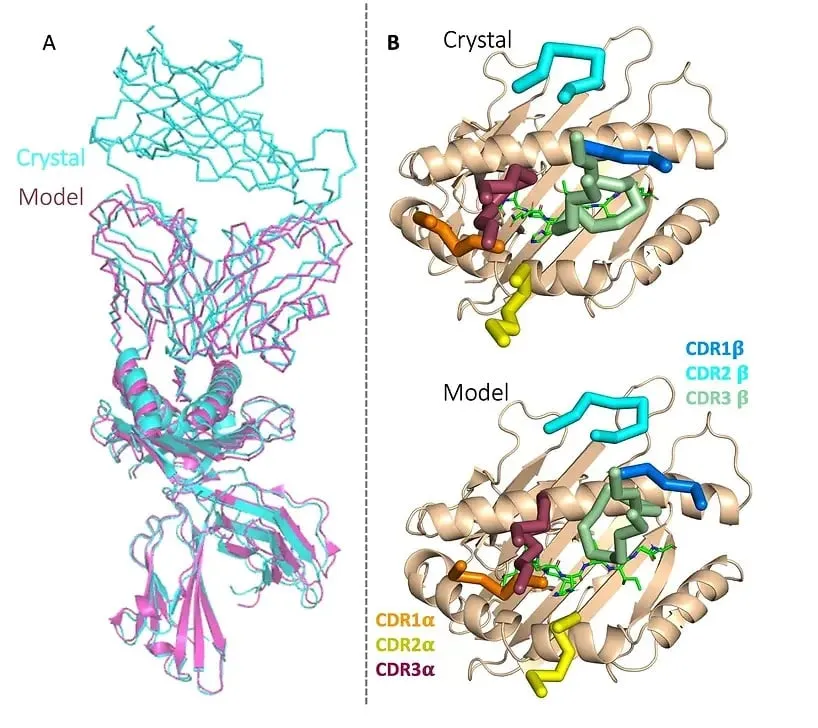

Британський біотехнологічний стартап Etcembly оголосив, що зміг використати генеративний штучний інтелект для розробки нової імунотерапії, націленої на важковиліковні види раку. До розробки долучилися й спеціалісти Nvidia Inception. Таким чином команда змогла створити протокол всього за 11 місяців — це вдвічі швидше, ніж традиційними методами.

Новий терапевтичний препарат Etcembly під назвою ETC-101 є біоспецифічним інгібітором Т-клітин — він націлений на білок, який міститься у багатьох видах раку, а не у здоровій тканині. Компанія заявляє, що вона також має потужний конвеєр інших імунотерапевтичних засобів для лікування раку та аутоімунних захворювань, розроблених на основі її ШІ-двигуна під назвою EMLy.

«Etcembly народився з нашого бажання об'єднати дві концепції, які випереджають науковий мейнстрім — TCR і генеративний ШІ — для розробки наступного покоління імунотерапії», — зазначила генеральна директорка проекту Мішель Тенг. — «Я дуже рада, що ми зможемо використати ці ресурси, щоб зробити майбутнє TCR-терапії реальністю і запропонувати пацієнтам трансформаційні методи лікування».

Разом із тим вчені погоджуються з думкою, що люди не повинні сліпо слідувати порадам штучного інтелекту. Нове дослідження, опубліковане в JAMA Oncology, свідчить про те, що ChatGPT має критичні обмеження при створенні планів лікування раку. Якщо рекомендації ШІ будуть впроваджуватися у клінічну практику без ретельної перевірки, це, на думку дослідників, створить ризикові для життя пацієнтів ситуації.

Так дослідники з Жіночої лікарні Брігама у Бостоні виявили, що рекомендації ChatGPT щодо лікування різних видів раку містять багато фактичних помилок і суперечливої інформації. Згідно з дослідженням, опублікованим в журналі JAMA Oncology, зі 104 запитів близько третини відповідей ChatGPT містили невірні дані.

Хоча 98% планів містили деякі точні рекомендації, майже всі вони містили змішані правильні та неправильні положення.

«Ми були вражені тим, наскільки невірна інформація була змішана з точними фактами, що ускладнювало виявлення помилок навіть для фахівців», — зазначила співавтор дослідження д-р Даніель Біттерман.

Зокрема, дослідження показало, що 12,5% рекомендацій щодо лікування від ChatGPT були або цілковитими галюцинаціями ШІ, або сфабриковані ботом без жодної фактичної точності. Особливі проблеми виникли з генеруванням надійних локалізованих методів лікування раку на пізніх стадіях і правильним застосуванням імунотерапевтичних препаратів.

Раніше компанія OpenAI попереджала, що ChatGPT не призначений для надання медичних консультацій або діагностики серйозних захворювань. Однак дослідники наголошують: навіть якщо це і так, схильність ШІ-моделі «впевнено» відповідати, оперуючи суперечливою або неправдивою інформацією підвищує ризики дуже серйозних проблем, які можуть загрожувати людському життю.